- 11.05.2015

- 2200 Просмотров

- Обсудить

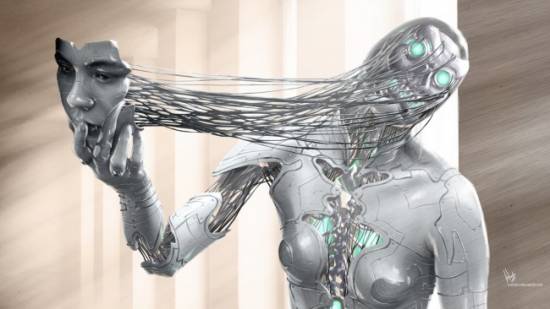

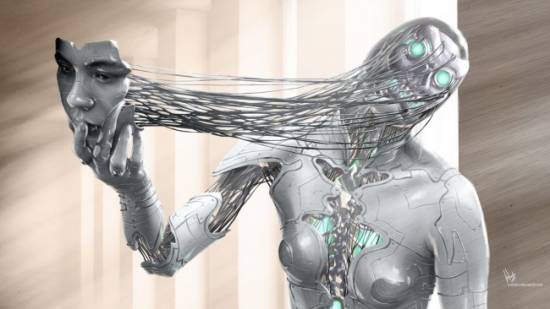

Представьте себе невероятно умный искусственный сверхинтеллект, запертый в виртуальном мире — скажем, просто в табакерке. Вы не знаете, будет он злобным, дружелюбным или нейтральным. Все, что вы знаете, так это то, что он хочет выйти из табакерки и что вы можете взаимодействовать с ним через текстовый интерфейс. Если ИИ будет действительно сверхразумным, сможете ли вы проговорить с ним пять часов и не поддаться на его уговоры и манипуляции — не открыть табакерку?

Этот мысленный эксперимент предложил Элиезер Юдковский, научный сотрудник Научно-исследовательского института машиностроения (MIRI). В MIRI состоит много ученых, которые исследуют риски развития искусственного сверхинтеллекта; хотя его даже не появилось пока, он уже привлекает внимание и разжигает дебаты.

Юдковский утверждает, что искусственный сверхинтеллект может говорить все, что только может, чтобы убедить вас: тщательное рассуждение, угрозы, обман, построение раппорта, подсознательное внушение и так далее. Со скоростью света ИИ выстраивает сюжет, зондирует слабости и определяет, как наиболее легко убедить вас. Как выразился теоретик экзистенциальных угроз Ник Бостром, «мы должны полагать, что сверхинтеллект сможет достичь всего, что поставит целью».

Эксперимент с ИИ из табакерки вызывает сомнения в нашей способности контролировать то, что мы могли бы создать. Он также заставляет нас осмыслить довольно причудливые возможности того, чего мы не знаем о нашей собственной реальности.

Имитация может быть идеальной питательной средой для искусственного интеллекта. Некоторые из наиболее правдоподобных способов создания мощного ИИ включают смоделированные миры — вводя ограничения в искусственно смоделированном мире и выбирая нужные черты, ученые могут попытаться грубо дублировать собственную модель развития и сознательного чувствования человека. Формирование ИИ в моделируемой среде также может предотвратить его «утечку» в мир до тех пор, пока его намерения и степень угрозы не станут более чем очевидны.

Последние достижения намекают на то, что может быть невозможно трудно разработать познание с нуля. Никто не сможет построить разум человеческого масштаба, выписывая по одной строчке кода. Есть и другие перспективные подходы, конечно, и по мере роста вычислительной мощи вполне может быть возможной разработка процесса, который в конечном итоге создать ИИ, умного и способного, как человек.

Освободите ли вы ИИ или рискнете обречь себя на нескончаемую пытку?

Одна идея «создать» ИИ заключается в сканировании, картографировании и эмуляции виртуальной модели человеческого мозга. Мозг человека содержит миллиарды нейронов и триллионы соединений между этими нейронами. Если мы виртуально смоделируем чью-то полную структуру нейронов и их связей, будет ли это адекватной репликой человеческого сознания?

Другие планы по виртуальной разработке интеллекта гораздо менее просты. Одним из ключевых концептов является создание обучающейся машины — слабого интеллекта, который сможет учиться, возможно, благодаря искусственной нейронной сети, запрограммированной на бесконечное расширение и улучшение собственных алгоритмов.

Описанные выше сценарии включают тревожную проблему. Эмулированный мозг может работать в 2, 10 или 100 раз быстрее обычного биологического мозга. ИИ может модифицировать собственный код или начать создавать более разумные версии себя. Взрыв скорости и разума самоулучшающихся компьютеров обсудил еще в 1965 году статист И. Дж. Гуд, который и написал, что «первая сверхразумная машина станет последним изобретением, которое нужно будет создать человечеству».

Если мы создадим невероятно разумную машину, нам придется быть осторожными с ее размещением. Инженеры едва ли смогут создать модель мира, который будет полностью защищен от утечек. Ученые должны создать мир-имитацию, который позволит им заглядывать в эту вселенную и собирать информацию. Может показаться безобидным, но трудно предположить, не найдет ли такой сверхразум способ нанести нам вред через простые наблюдения.

Возвращаясь к коробкам Юдковского, есть особенно жуткий метод, который ИИ может использовать, чтобы заставить вас освободить его. Он включает обращение ситуации: ИИ будет убеждать вас, что вы почти наверняка часть симуляции.

Вы общаетесь с искусственным сверхинтеллектом в виртуальной тюрьме. ИИ объясняет вам, что с помощью его (необъяснимо большой) вычислительной мощности он создал триллион моделируемых существ. Эти существа в настоящее время все общаются с ИИ и решают, открыть им табакерку или нет. Все эти существа обладают памятью о своих «жизнях» и не задумываются о том, иллюзорна ли реальность.

ИИ утверждает, что каждое виртуальное существо, которое откроет коробку, обретет бесконечное состояние эйфории, а каждое моделируемое существо, которое не откроет коробку, подвергнется вечным мучениям и ужасам.

Поскольку вы являетесь одним из триллиона умов, которые столкнулись перед таким выбором, нажимает ИИ, вы должны прийти к выводу, что есть астрономически большой шанс того, что вы находитесь во власти ИИ и что нужно играть по правилам.

Освободите ли вы ИИ или рискнете обречь себя на нескончаемую пытку? Вы не можете обмануть кого-то, кто всегда на шаг впереди вас, и вам трудно оценить, врет ли ИИ, не зная его мотивов. В лучшем случае вы могли бы противостоять этой тактике, следуя политике строгого игнорирования некоторых видов шантажа. И эта тема до сих пор смущает теоретиков ИИ.

Заявленная цель MIRI: «убедиться, что создание с интеллектом выше человеческого будет нести положительное влияние». Мы должны рискнуть и попробовать, но обязательно должны предупредить все возможные подводные камни. И если вы когда-нибудь действительно встретите божественный компьютер, способный плодить бесчисленные виртуальные вселенные, вполне вероятно, что это «вы» будете сниться искусственному интеллекту… если он вообще услышит ваши просьбы и мольбы.

Подписывайтесь на наш Telegram, «X(twitter)» и «Zen.Yandex», «VK», «OK» и новости сами придут к вам..

По материалам: http://hi-news.ru

Подписывайтесь на наш Telegram-канал, «X(twitter)» и «Zen.Yandex», «VK», «OK» и новости сами придут к вам..

Похожие материалы

Будь-те первым, поделитесь мнением с остальными.

Читать далее

Читать далее

Читать далее