- 04.06.2016

- 1513 Просмотров

- Обсудить

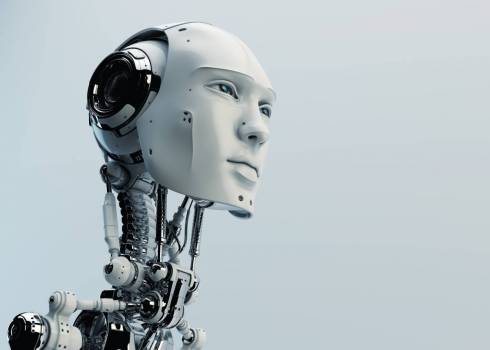

Специалисты представили новый способ, с помощью которого можно обезвредить искусственный интеллект. Он сможет помочь в тех случаях, когда ИИ выйдет из-под контроля.

С деталями можно ознакомиться в издании Business Insider, которое ссылается на Институт изучения машинного интеллекта. Сейчас, когда уровень развития искусственного интеллекта достаточно высок, многие всерьез опасаются, что ИИ выйдет из-под контроля. Не дать катастрофе случиться поможет новый метод, представленный специалистами Оксфордского университета, а также их коллегами из лаборатории DeepMind, которая принадлежит корпорации Google.

Отметим, что именно DeepMind создала компьютерную программу AlphaGo, которая победила в древнекитайскую игру го чемпиона Европы по этой дисциплине Фаня Хуэя. Причем сделала это с разгромным счетом 5:0. В этом событии нет, на первый взгляд, ничего странного: ранее компьютер уже побеждал человека в шашки и шахматы. Но дело в том, что в го почти никак нельзя перебрать все возможные комбинации. Поэтому ИИ сложно предсказать дальнейший вариант развития событий.

Специалисты представили новый способ, с помощью которого можно обезвредить искусственный интеллект. Он сможет помочь в тех случаях, когда ИИ выйдет из-под контроля.

Это и многие другие достижения в вопросе развития ИИ породили вполне понятные опасения. И сейчас эксперты хотят обезопасить мир от «злобных роботов». По словам специалистов, речь идет о некой «большой красной кнопке». Работа, посвященная ей, представляет собой математический анализ, который описывает методы построения защиты. «Если такой агент (имеется в виду ИИ) работает в режиме реального времени под наблюдением человека, то иногда может возникнуть ситуация, при которой оператор будет вынужден нажать на большую красную кнопку, чтобы остановить агента от выполнения действий, опасных для самого агента или его окружения», – говорится в исследовании.

Считается, что на каком-то этапе искусственный интеллект сможет найти лазейку, которая позволит ему игнорировать обычную стоп-команду человека. Целью новой исследовательской работы стал поиск способов предотвратить нечто подобное.

Об угрозе со стороны ИИ мы слышим в последнее время все чаще. Об этом, в частности, предупреждают такие видные деятели нашего времени, как Стивен Хокинг, Билл Гейтс и Илон Маск. Все они делают акцент на невероятно быстрых темпах развития искусственного интеллекта.

Напомним, ранее научно-популярный портал Naked Science попытался разобраться в вопросах, связанных с возможными угрозами со стороны ИИ. Были рассмотрены разные прогнозы от различных специалистов: как условно «позитивные», так и условно «негативные».

Подписывайтесь на наш Telegram, «X(twitter)» и «Zen.Yandex», «VK», «OK» и новости сами придут к вам..

По материалам: https://naked-science.ru

Подписывайтесь на наш Telegram-канал, «X(twitter)» и «Zen.Yandex», «VK», «OK» и новости сами придут к вам..

Похожие материалы

Будь-те первым, поделитесь мнением с остальными.

Читать далее

Читать далее